AI+Decodo:构建智能电商价格监控系统的完整实战指南

在现代电商环境中,价格监控已成为商家和消费者的刚需。然而传统的网页爬虫面临着反爬虫机制越来越严格、网页结构复杂多变、IP被封禁等诸多挑战。本文将详细介绍如何结合AI智能分析与高质量代理池,构建一个既稳定又智能的电商价格监控系统。

Kristina Selivanovaite

最后更新: 10月 16日, 2025年

4 分钟阅读

一、技术背景与挑战分析

传统爬虫的痛点

现代电商网站的反爬虫机制日趋完善,传统爬虫面临以下核心挑战:

- 网络访问层面的严格限制:IP 频繁访问被封禁、User-Agent 识别与拦截,导致数据获取困难。

- 页面结构的动态复杂性:动态 JavaScript 渲染内容、页面结构频繁变更,传统静态解析方式已无法适应。

- 数据提取的多样性挑战:价格格式千变万化、库存状态表达不统一,不同平台数据呈现差异大,需更智能的识别能力。

不同平台的数据呈现方式差异巨大,需要更智能的识别和解析能力。

解决方案架构

为了解决这些问题,我们设计了一个"AI + 代理池"的智能抓取架构:

[目标网站] ← [高质量代理池] ← [智能请求管理] ← [AI内容分析] ← [结构化输出]

[目标网站] ← [高质量代理池] ← [智能请求管理] ← [AI内容分析] ← [结构化输出]

核心设计思路:

- 代理池负责网络身份管理,实现IP轮换和访问伪装

- AI负责内容理解分析,智能识别和提取关键信息

这种架构将网络访问和内容分析分离,各司其职,大幅提升了系统的稳定性和智能化水平。

二、实战开发:构建智能监控系统

环境准备与核心依赖

首先需通过 pip 安装相关库:

pip install requests beautifulsoup4 openai loguru pandas urllib3 python-dotenv regex

pip install requests beautifulsoup4 openai loguru pandas urllib3 python-dotenv regex

项目构建需要合理的技术栈组合:

# 核心依赖包import requests # HTTP请求处理from bs4 import BeautifulSoup # HTML解析import openai # AI模型调用from loguru import logger # 智能日志import pandas as pd # 数据处理import urllib3 # 网络优化from typing import Optional, Dict, Listimport reimport jsonimport randomimport timeimport datetime

# 核心依赖包import requests # HTTP请求处理from bs4 import BeautifulSoup # HTML解析import openai # AI模型调用from loguru import logger # 智能日志import pandas as pd # 数据处理import urllib3 # 网络优化from typing import Optional, Dict, Listimport reimport jsonimport randomimport timeimport datetime

关键配置优化:

# 屏蔽SSL证书警告,提高请求成功率urllib3.disable_warnings(urllib3.exceptions.InsecureRequestWarning)# 配置智能日志系统logger.add("price_monitor.log", rotation="1 day", level="INFO")

# 屏蔽SSL证书警告,提高请求成功率urllib3.disable_warnings(urllib3.exceptions.InsecureRequestWarning)# 配置智能日志系统logger.add("price_monitor.log", rotation="1 day", level="INFO")

这些配置能够有效减少网络请求中的干扰因素,提升系统稳定性。

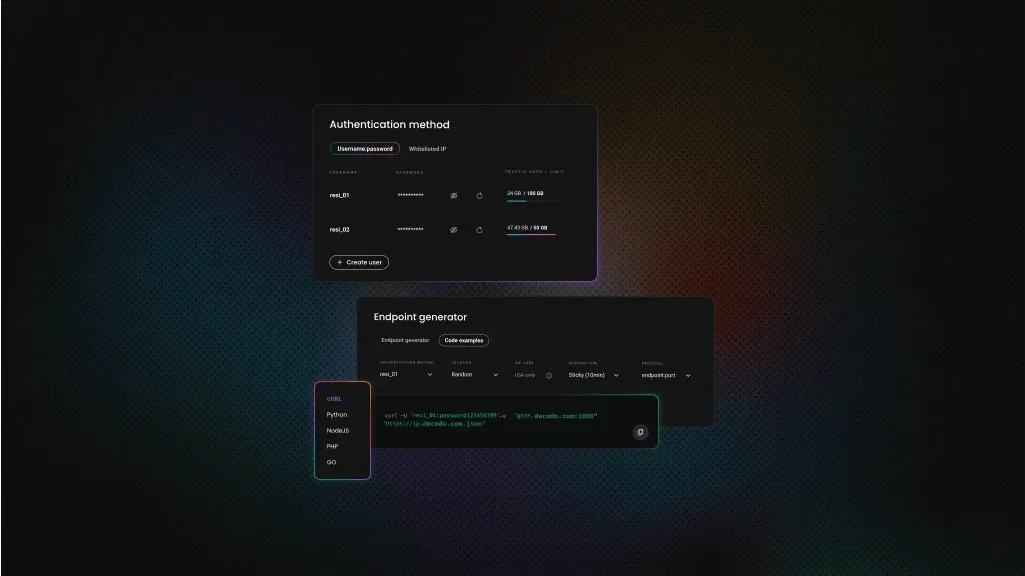

Decodo代理池管理核心实现

代理池是整个系统的网络基础,我们选择Decodo作为代理服务提供商,Decodo代理的核心优势是:

- 高匿名度IP,有效规避识别

- 多地域节点覆盖

这确保了访问的稳定性和隐蔽性,大幅提升抓取成功率。

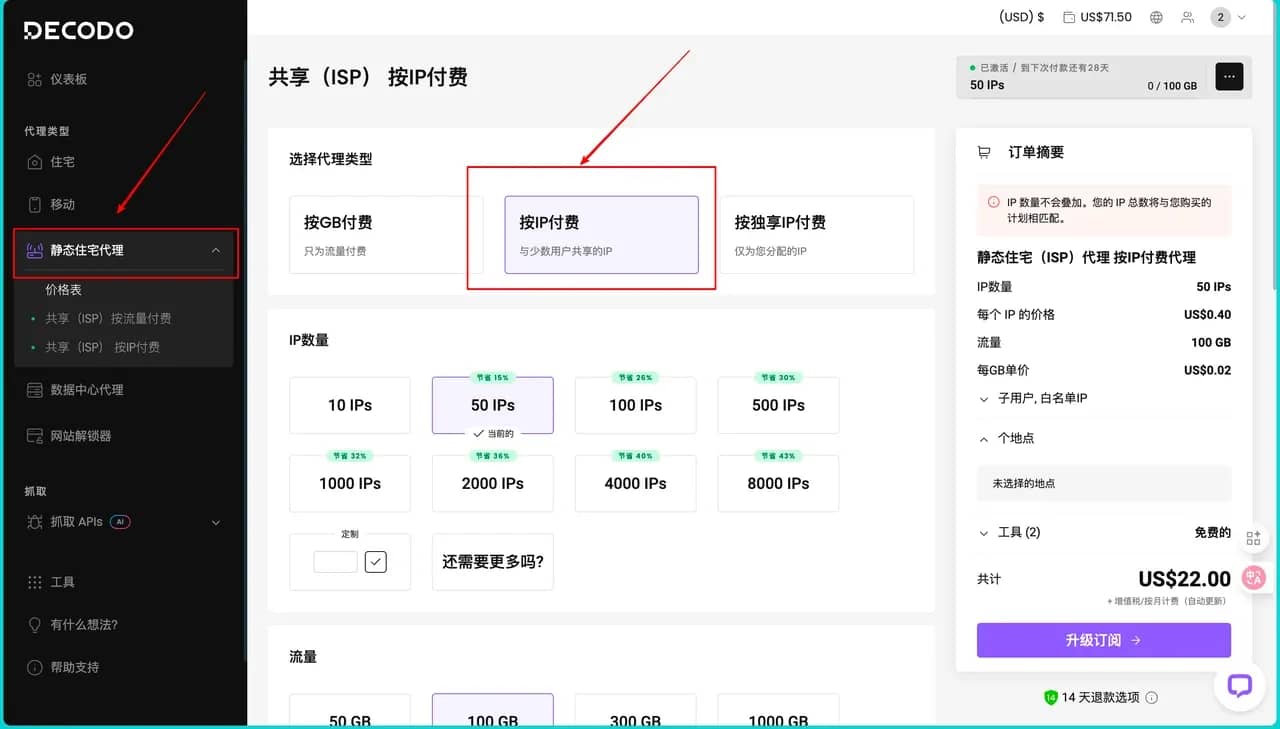

这些代理节点不仅分布在不同端口,还具备动态切换能力,当某个代理出现响应延迟或连接失败时,系统会自动将其从可用列表中移除,确保始终使用状态最佳的代理进行网络请求。获取这些 Decodo 代理的方式首先需要我们注册Decodo平台的账户,然后其控制台会出现在我们眼前,在控制台左侧导航栏找到 “静态住宅代理”。在页面上方 “选择代理类型” 区域,确认选中 “按 IP 付费”(与少数用户共享的 IP)这一选项。

然后在 “IP 数量” 板块,我们根据需求选择预设的 IP 数量,因为我下面的项目中需要的IP 数量并不是很多,所以这个地方我仅需要选择50个即可,同时我们也可以根据自己需要勾选定制输入自定义数量。同理在 “流量” 板块,我们也直接根据需要选择所需的流量额度即可完成。

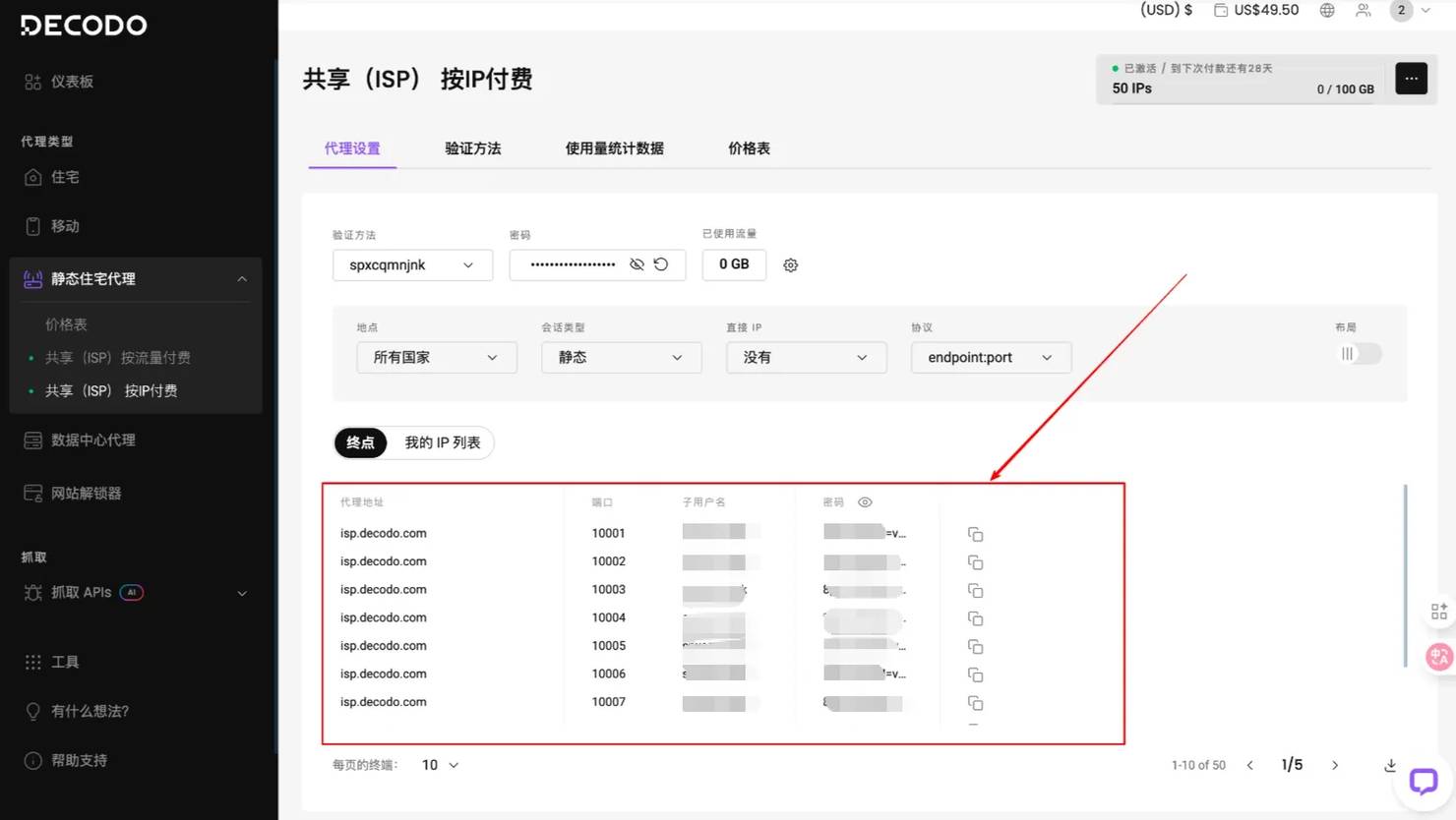

右侧 “订单摘要” 会实时显示所选配置的费用明细,确认 IP 数量、流量、单价等信息无误后,点击订阅即可完成,获取对应的代理资源。然后直接会弹出我们刚才购买好的界面,这里会显示出我们需要的用户的代理地址用户名以及密码:

将如上的用户信息输入我们预订好的代码中,如下面所示,这里我并不展示所有的用户,大家可以参考这个格式去实现自己的配置

url = 'https://ip.decodo.com/json'username = '填入自己的'password = '填入自己的'proxy = f"http://{username}:{password}@isp.decodo.com:10001"

url = 'https://ip.decodo.com/json'username = '填入自己的'password = '填入自己的'proxy = f"http://{username}:{password}@isp.decodo.com:10001"

class SimpleProxyManager:"""基于Decodo的智能代理管理器"""def __init__(self):# Decodo代理配置 – 多端口负载均衡base_url = "http://spxcqmnjnk:8pUFd76rM=vgmVee6o@isp.decodo.com"ports = [10001, 10002, 10003, 10004]self.proxies = [{"http": f"{base_url}:{port}","https": f"{base_url}:{port}"}for port in ports]self.current_index = 0def get_proxy(self) -> Optional[Dict]:"""智能代理获取 - 轮询算法"""if not self.proxies:return Noneproxy = self.proxies[self.current_index]self.current_index = (self.current_index + 1) % len(self.proxies)return proxydef remove_proxy(self, proxy: Dict):"""失效代理自动移除"""if proxy in self.proxies:self.proxies.remove(proxy)logger.warning(f"移除失效代理: {proxy}")

class SimpleProxyManager:"""基于Decodo的智能代理管理器"""def __init__(self):# Decodo代理配置 – 多端口负载均衡base_url = "http://spxcqmnjnk:8pUFd76rM=vgmVee6o@isp.decodo.com"ports = [10001, 10002, 10003, 10004]self.proxies = [{"http": f"{base_url}:{port}","https": f"{base_url}:{port}"}for port in ports]self.current_index = 0def get_proxy(self) -> Optional[Dict]:"""智能代理获取 - 轮询算法"""if not self.proxies:return Noneproxy = self.proxies[self.current_index]self.current_index = (self.current_index + 1) % len(self.proxies)return proxydef remove_proxy(self, proxy: Dict):"""失效代理自动移除"""if proxy in self.proxies:self.proxies.remove(proxy)logger.warning(f"移除失效代理: {proxy}")

代理管理的核心设计理念就是轮询机制避免单点过载,同时要达到失效代理实时清理,这样通过智能化的代理调度,就可以确保我们的系统具有高可用性和稳定性。

AI内容分析引擎

这是AI分析内容的主要部分,负责理解复杂的电商页面结构,AI分析的关键优势:智能识别页面主要内容,同时自动过滤广告和无关信息。AI模型能够理解页面的语义结构,准确提取商品核心信息。

prompt = f"""请分析以下电商页面内容,提取商品信息。返回JSON格式:网页URL: {url} 网页内容: {text_content}请提取:1. product_name: 商品名称2. current_price: 当前价格(只要数字,去掉货币符号)3. original_price: 原价(如果有)4. stock_status: 库存状态5. is_available: 是否有货(true/false) 只返回JSON,不要其他文字。"""

prompt = f"""请分析以下电商页面内容,提取商品信息。返回JSON格式:网页URL: {url} 网页内容: {text_content}请提取:1. product_name: 商品名称2. current_price: 当前价格(只要数字,去掉货币符号)3. original_price: 原价(如果有)4. stock_status: 库存状态5. is_available: 是否有货(true/false) 只返回JSON,不要其他文字。"""

大家在设置的时候可以参考我的提示词给 AI 明确的指令,这样能让 AI 更精准地理解需求,减少无效输出。下面是完整的工具类代码,已针对 OpenAI API 版本兼容和密钥安全配置做了优化:

import osimport reimport jsonfrom bs4 import BeautifulSoupfrom openai import OpenAI # 适配新版OpenAI SDK(v1.0.0+)from dotenv import load_dotenv # 用于安全加载环境变量,避免密钥硬编码from loguru import loggerfrom typing import Dict# 先加载环境变量(建议在项目根目录创建.env文件存储敏感信息)load_dotenv()class AIAnalyzer:"""基于GPT的智能内容分析器,专注电商页面商品信息提取"""def __init__(self):"""初始化OpenAI客户端,提前校验API密钥配置"""# 从环境变量获取API密钥,而非直接写在代码里,降低泄露风险self.openai_api_key = os.getenv("OPENAI_API_KEY")if not self.openai_api_key:raise ValueError("请先配置OpenAI API密钥!可在.env文件中添加'OPENAI_API_KEY=你的密钥',或设置系统环境变量")# 初始化新版OpenAI客户端self.client = OpenAI(api_key=self.openai_api_key)logger.info("OpenAI客户端初始化完成,已准备好进行商品信息分析")def extract_product_info(self, html_content: str, url: str) -> Dict:"""使用AI智能提取商品信息:param html_content: 电商页面的HTML源代码:param url: 对应页面的URL(用于辅助AI理解上下文):return: 包含商品信息的字典,或错误提示"""# 第一步:HTML内容预处理——移除无关元素,减少AI分析干扰soup = BeautifulSoup(html_content, 'html.parser')# 剔除脚本、样式、导航栏等非商品核心内容for tag in soup(['script', 'style', 'nav', 'footer', 'header', 'aside']):tag.decompose()# 提取纯文本并控制长度(避免超出AI tokens限制)text_content = soup.get_text(separator=' ', strip=True)if len(text_content) > 3000:text_content = text_content[:3000] + "...(内容过长,已截取前3000字符)"logger.debug(f"预处理后待分析文本长度:{len(text_content)}字符")# 第二步:构建精准提示词——明确AI任务边界和输出格式prompt = f"""请分析以下电商页面内容,提取商品信息。返回JSON格式:网页URL: {url}网页内容: {text_content}请提取:1. product_name: 商品名称2. current_price: 当前价格(只要数字,去掉货币符号)3. original_price: 原价(如果有)4. stock_status: 库存状态5. is_available: 是否有货(true/false)只返回JSON,不要其他文字。"""try:# 第三步:调用OpenAI API——使用新版接口格式response = self.client.chat.completions.create(model="gpt-3.5-turbo", # 平衡效果与成本,也可替换为"gpt-4"提升精度messages=[{"role": "system", "content": "你是专注于电商数据提取的工具,输出仅JSON,无多余内容"},{"role": "user", "content": prompt}],temperature=0.1, # 降低随机性,确保输出格式稳定max_tokens=300, # 限制输出长度,避免冗余timeout=10 # 设置超时时间,防止长期阻塞)# 提取AI响应内容并解析JSONresult_text = response.choices[0].message.content.strip()# 用正则匹配JSON结构(防止AI偶尔多输出文字)json_match = re.search(r'\{[\s\S]*\}', result_text, re.DOTALL)if json_match:result = json.loads(json_match.group())# 补充URL字段,方便后续追溯数据来源result["source_url"] = urllogger.success(f"成功提取商品信息:{result.get('product_name', '未知商品')}(来自{url})")return resultelse:logger.error(f"AI返回内容格式错误,未匹配到JSON:{result_text[:150]}...")return {"error": "AI返回格式错误", "source_url": url, "raw_response": result_text[:200]}except Exception as e:error_msg = f"商品信息提取失败:{str(e)}"logger.error(f"{error_msg}(URL:{url})")return {"error": error_msg, "source_url": url}

import osimport reimport jsonfrom bs4 import BeautifulSoupfrom openai import OpenAI # 适配新版OpenAI SDK(v1.0.0+)from dotenv import load_dotenv # 用于安全加载环境变量,避免密钥硬编码from loguru import loggerfrom typing import Dict# 先加载环境变量(建议在项目根目录创建.env文件存储敏感信息)load_dotenv()class AIAnalyzer:"""基于GPT的智能内容分析器,专注电商页面商品信息提取"""def __init__(self):"""初始化OpenAI客户端,提前校验API密钥配置"""# 从环境变量获取API密钥,而非直接写在代码里,降低泄露风险self.openai_api_key = os.getenv("OPENAI_API_KEY")if not self.openai_api_key:raise ValueError("请先配置OpenAI API密钥!可在.env文件中添加'OPENAI_API_KEY=你的密钥',或设置系统环境变量")# 初始化新版OpenAI客户端self.client = OpenAI(api_key=self.openai_api_key)logger.info("OpenAI客户端初始化完成,已准备好进行商品信息分析")def extract_product_info(self, html_content: str, url: str) -> Dict:"""使用AI智能提取商品信息:param html_content: 电商页面的HTML源代码:param url: 对应页面的URL(用于辅助AI理解上下文):return: 包含商品信息的字典,或错误提示"""# 第一步:HTML内容预处理——移除无关元素,减少AI分析干扰soup = BeautifulSoup(html_content, 'html.parser')# 剔除脚本、样式、导航栏等非商品核心内容for tag in soup(['script', 'style', 'nav', 'footer', 'header', 'aside']):tag.decompose()# 提取纯文本并控制长度(避免超出AI tokens限制)text_content = soup.get_text(separator=' ', strip=True)if len(text_content) > 3000:text_content = text_content[:3000] + "...(内容过长,已截取前3000字符)"logger.debug(f"预处理后待分析文本长度:{len(text_content)}字符")# 第二步:构建精准提示词——明确AI任务边界和输出格式prompt = f"""请分析以下电商页面内容,提取商品信息。返回JSON格式:网页URL: {url}网页内容: {text_content}请提取:1. product_name: 商品名称2. current_price: 当前价格(只要数字,去掉货币符号)3. original_price: 原价(如果有)4. stock_status: 库存状态5. is_available: 是否有货(true/false)只返回JSON,不要其他文字。"""try:# 第三步:调用OpenAI API——使用新版接口格式response = self.client.chat.completions.create(model="gpt-3.5-turbo", # 平衡效果与成本,也可替换为"gpt-4"提升精度messages=[{"role": "system", "content": "你是专注于电商数据提取的工具,输出仅JSON,无多余内容"},{"role": "user", "content": prompt}],temperature=0.1, # 降低随机性,确保输出格式稳定max_tokens=300, # 限制输出长度,避免冗余timeout=10 # 设置超时时间,防止长期阻塞)# 提取AI响应内容并解析JSONresult_text = response.choices[0].message.content.strip()# 用正则匹配JSON结构(防止AI偶尔多输出文字)json_match = re.search(r'\{[\s\S]*\}', result_text, re.DOTALL)if json_match:result = json.loads(json_match.group())# 补充URL字段,方便后续追溯数据来源result["source_url"] = urllogger.success(f"成功提取商品信息:{result.get('product_name', '未知商品')}(来自{url})")return resultelse:logger.error(f"AI返回内容格式错误,未匹配到JSON:{result_text[:150]}...")return {"error": "AI返回格式错误", "source_url": url, "raw_response": result_text[:200]}except Exception as e:error_msg = f"商品信息提取失败:{str(e)}"logger.error(f"{error_msg}(URL:{url})")return {"error": error_msg, "source_url": url}

OpenAI所需要的API需要我们去访问官网:官网,完成注册之后进入API Keys页面,去创建我们自己的新密钥,然后设置合理的使用限额避免超支,这里我们需要的GPT-3.5-turbo价格约为$0.002/1K tokens。

智能请求管理与重试机制

结合代理池和AI分析,构建智能的网页获取系统:

def fetch_page(self, url: str, max_retries: int = 3) -> tuple[str, bool]:"""智能网页获取,包含重试和代理切换"""for attempt in range(max_retries):proxy = self.proxy_manager.get_proxy()# 代理池耗尽时的降级策略if not proxy:logger.warning("没有可用代理,尝试直接连接")proxy = Nonetry:response = self.session.get(url,proxies=proxy,timeout=(5, 20), # 连接超时5秒,读取超时20秒verify=False)if response.status_code == 200:logger.info(f"成功获取页面: {url}")return response.text, Trueelif response.status_code in [403, 429, 503]:logger.warning(f"访问受限 {response.status_code}, 更换代理重试")if proxy:self.proxy_manager.remove_proxy(proxy)except requests.exceptions.ReadTimeout:logger.warning(f"读取超时,尝试更换代理 (尝试 {attempt + 1}/{max_retries})")if proxy:self.proxy_manager.remove_proxy(proxy)except Exception as e:logger.error(f"请求异常: {str(e)}")if proxy:self.proxy_manager.remove_proxy(proxy)# 指数退避重试策略delay = random.uniform(2 + attempt * 2, 5 + attempt * 2)logger.info(f"等待 {delay:.1f} 秒后重试...")time.sleep(delay)return "", False

def fetch_page(self, url: str, max_retries: int = 3) -> tuple[str, bool]:"""智能网页获取,包含重试和代理切换"""for attempt in range(max_retries):proxy = self.proxy_manager.get_proxy()# 代理池耗尽时的降级策略if not proxy:logger.warning("没有可用代理,尝试直接连接")proxy = Nonetry:response = self.session.get(url,proxies=proxy,timeout=(5, 20), # 连接超时5秒,读取超时20秒verify=False)if response.status_code == 200:logger.info(f"成功获取页面: {url}")return response.text, Trueelif response.status_code in [403, 429, 503]:logger.warning(f"访问受限 {response.status_code}, 更换代理重试")if proxy:self.proxy_manager.remove_proxy(proxy)except requests.exceptions.ReadTimeout:logger.warning(f"读取超时,尝试更换代理 (尝试 {attempt + 1}/{max_retries})")if proxy:self.proxy_manager.remove_proxy(proxy)except Exception as e:logger.error(f"请求异常: {str(e)}")if proxy:self.proxy_manager.remove_proxy(proxy)# 指数退避重试策略delay = random.uniform(2 + attempt * 2, 5 + attempt * 2)logger.info(f"等待 {delay:.1f} 秒后重试...")time.sleep(delay)return "", False

智能重试的核心特性:

- 根据HTTP状态码智能判断

- 指数退避避免频繁重试

这种机制能够有效应对各种网络异常,提升整体成功率。

完整的监控流程实现

将所有组件整合,构建完整的商品监控流程:

def monitor_product(self, url: str) -> Dict:"""单个商品完整监控流程"""logger.info(f"开始监控商品: {url}")# 步骤1:通过代理获取页面内容html_content, success = self.fetch_page(url)if not success:return {"url": url,"success": False,"error": "无法获取页面内容","timestamp": datetime.now().strftime('%Y-%m-%d %H:%M:%S')}# 步骤2:AI分析提取信息product_info = self.ai_analyzer.extract_product_info(html_content, url)if "error" in product_info:return {"url": url,"success": False,"error": product_info["error"],"timestamp": datetime.now().strftime('%Y-%m-%d %H:%M:%S')}# 步骤3:数据处理和结构化current_price = self._extract_price(product_info.get('current_price'))original_price = self._extract_price(product_info.get('original_price'))result = {"url": url,"success": True,"product_name": product_info.get('product_name', ''),"current_price": current_price,"original_price": original_price,"stock_status": product_info.get('stock_status', ''),"is_available": product_info.get('is_available', False),"discount": self._calculate_discount(original_price, current_price),"timestamp": datetime.now().strftime('%Y-%m-%d %H:%M:%S')}logger.success(f"监控成功: {result['product_name']} - ¥{current_price}")return result

def monitor_product(self, url: str) -> Dict:"""单个商品完整监控流程"""logger.info(f"开始监控商品: {url}")# 步骤1:通过代理获取页面内容html_content, success = self.fetch_page(url)if not success:return {"url": url,"success": False,"error": "无法获取页面内容","timestamp": datetime.now().strftime('%Y-%m-%d %H:%M:%S')}# 步骤2:AI分析提取信息product_info = self.ai_analyzer.extract_product_info(html_content, url)if "error" in product_info:return {"url": url,"success": False,"error": product_info["error"],"timestamp": datetime.now().strftime('%Y-%m-%d %H:%M:%S')}# 步骤3:数据处理和结构化current_price = self._extract_price(product_info.get('current_price'))original_price = self._extract_price(product_info.get('original_price'))result = {"url": url,"success": True,"product_name": product_info.get('product_name', ''),"current_price": current_price,"original_price": original_price,"stock_status": product_info.get('stock_status', ''),"is_available": product_info.get('is_available', False),"discount": self._calculate_discount(original_price, current_price),"timestamp": datetime.now().strftime('%Y-%m-%d %H:%M:%S')}logger.success(f"监控成功: {result['product_name']} - ¥{current_price}")return result

监控流程的优势:

- 网络层和分析层职责分离

- 完整的错误处理和日志记录

每个环节都有详细的状态跟踪,便于问题定位和系统优化。

三、运行结果与性能分析

完整的工作流程

创建 PriceMonitor 主类,将代理管理、AI分析、网页抓取等功能模块有机整合,形成了一个完整的工作流程。让整个监控系统真正可以很简单的运行起来,现在我们只需配置好Decodo代理和OpenAI API密钥,就能立即开始监控心仪商品的价格变化,实现自动的电商价格追踪:

class PriceMonitor:"""完整的价格监控系统主类"""def __init__(self):"""初始化监控系统"""self.proxy_manager = SimpleProxyManager()self.ai_analyzer = AIAnalyzer()# 配置请求会话self.session = requests.Session()self.session.headers.update({'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36','Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8','Accept-Language': 'zh-CN,zh;q=0.9,en;q=0.8','Accept-Encoding': 'gzip, deflate','Connection': 'keep-alive',})logger.info("价格监控系统初始化完成")def fetch_page(self, url: str, max_retries: int = 3) -> tuple[str, bool]:"""智能网页获取,包含重试和代理切换"""for attempt in range(max_retries):proxy = self.proxy_manager.get_proxy()# 代理池耗尽时的降级策略if not proxy:logger.warning("没有可用代理,尝试直接连接")proxy = Nonetry:response = self.session.get(url,proxies=proxy,timeout=(5, 20), # 连接超时5秒,读取超时20秒verify=False)if response.status_code == 200:logger.info(f"成功获取页面: {url}")return response.text, Trueelif response.status_code in [403, 429, 503]:logger.warning(f"访问受限 {response.status_code}, 更换代理重试")if proxy:self.proxy_manager.remove_proxy(proxy)except requests.exceptions.ReadTimeout:logger.warning(f"读取超时,尝试更换代理 (尝试 {attempt + 1}/{max_retries})")if proxy:self.proxy_manager.remove_proxy(proxy)except Exception as e:logger.error(f"请求异常: {str(e)}")if proxy:self.proxy_manager.remove_proxy(proxy)# 指数退避重试策略delay = random.uniform(2 + attempt * 2, 5 + attempt * 2)logger.info(f"等待 {delay:.1f} 秒后重试...")time.sleep(delay)return "", Falsedef _extract_price(self, price_str) -> float:"""从字符串中提取价格数字"""if not price_str:return 0.0# 使用正则提取数字price_match = re.search(r'(\d+\.?\d*)', str(price_str))if price_match:return float(price_match.group(1))return 0.0def _calculate_discount(self, original_price: float, current_price: float) -> float:"""计算折扣百分比"""if original_price > 0 and current_price > 0:return round((original_price - current_price) / original_price * 100, 2)return 0.0def monitor_product(self, url: str) -> Dict:"""单个商品完整监控流程"""logger.info(f"开始监控商品: {url}")# 步骤1:通过代理获取页面内容html_content, success = self.fetch_page(url)if not success:return {"url": url,"success": False,"error": "无法获取页面内容","timestamp": datetime.now().strftime('%Y-%m-%d %H:%M:%S')}# 步骤2:AI分析提取信息product_info = self.ai_analyzer.extract_product_info(html_content, url)if "error" in product_info:return {"url": url,"success": False,"error": product_info["error"],"timestamp": datetime.now().strftime('%Y-%m-%d %H:%M:%S')}# 步骤3:数据处理和结构化current_price = self._extract_price(product_info.get('current_price'))original_price = self._extract_price(product_info.get('original_price'))result = {"url": url,"success": True,"product_name": product_info.get('product_name', ''),"current_price": current_price,"original_price": original_price,"stock_status": product_info.get('stock_status', ''),"is_available": product_info.get('is_available', False),"discount": self._calculate_discount(original_price, current_price),"timestamp": datetime.now().strftime('%Y-%m-%d %H:%M:%S')}logger.success(f"监控成功: {result['product_name']} - ¥{current_price}")return resultdef batch_monitor(self, urls: List[str]) -> List[Dict]:"""批量监控多个商品"""logger.info(f"开始批量监控 {len(urls)} 个商品")results = []for i, url in enumerate(urls, 1):logger.info(f"处理第 {i}/{len(urls)} 个商品")result = self.monitor_product(url)results.append(result)# 智能延迟控制if i < len(urls):delay = random.uniform(3, 8)logger.info(f"等待 {delay:.1f} 秒...")time.sleep(delay)return resultsdef price_alert(self, results: List[Dict], target_prices: Dict[str, float]):"""智能价格预警系统"""alerts = []for result in results:if not result.get('success'):continueurl = result['url']current_price = result['current_price']product_name = result['product_name']if url in target_prices and current_price > 0:target_price = target_prices[url]if current_price <= target_price:alert = {'product_name': product_name,'current_price': current_price,'target_price': target_price,'savings': target_price - current_price,'url': url,'timestamp': result['timestamp']}alerts.append(alert)print(f"\n🎉 价格预警触发!")print(f"商品:{product_name}")print(f"当前价格:¥{current_price}")print(f"目标价格:¥{target_price}")print(f"可节省:¥{alert['savings']:.2f}")print(f"链接:{url}")return alerts# 使用示例if __name__ == "__main__":# 创建监控系统实例monitor = PriceMonitor()# 要监控的商品URL列表urls_to_monitor = ["https://item.jd.com/100012043978.html", # 示例商品链接"https://detail.tmall.com/item.htm?id=123456789", # 示例商品链接]# 设置目标价格(当价格低于此值时触发预警)target_prices = {"https://item.jd.com/100012043978.html": 299.0,"https://detail.tmall.com/item.htm?id=123456789": 199.0,}# 执行批量监控results = monitor.batch_monitor(urls_to_monitor)# 检查价格预警alerts = monitor.price_alert(results, target_prices)# 输出监控结果print("\n=== 监控结果汇总 ===")for result in results:if result['success']:print(f"商品: {result['product_name']}")print(f"当前价格: ¥{result['current_price']}")print(f"库存状态: {result['stock_status']}")print(f"监控时间: {result['timestamp']}")print("-" * 50)else:print(f"监控失败: {result['url']} - {result['error']}")print(f"\n本次监控完成,共处理 {len(results)} 个商品,触发 {len(alerts)} 个价格预警")

class PriceMonitor:"""完整的价格监控系统主类"""def __init__(self):"""初始化监控系统"""self.proxy_manager = SimpleProxyManager()self.ai_analyzer = AIAnalyzer()# 配置请求会话self.session = requests.Session()self.session.headers.update({'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36','Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8','Accept-Language': 'zh-CN,zh;q=0.9,en;q=0.8','Accept-Encoding': 'gzip, deflate','Connection': 'keep-alive',})logger.info("价格监控系统初始化完成")def fetch_page(self, url: str, max_retries: int = 3) -> tuple[str, bool]:"""智能网页获取,包含重试和代理切换"""for attempt in range(max_retries):proxy = self.proxy_manager.get_proxy()# 代理池耗尽时的降级策略if not proxy:logger.warning("没有可用代理,尝试直接连接")proxy = Nonetry:response = self.session.get(url,proxies=proxy,timeout=(5, 20), # 连接超时5秒,读取超时20秒verify=False)if response.status_code == 200:logger.info(f"成功获取页面: {url}")return response.text, Trueelif response.status_code in [403, 429, 503]:logger.warning(f"访问受限 {response.status_code}, 更换代理重试")if proxy:self.proxy_manager.remove_proxy(proxy)except requests.exceptions.ReadTimeout:logger.warning(f"读取超时,尝试更换代理 (尝试 {attempt + 1}/{max_retries})")if proxy:self.proxy_manager.remove_proxy(proxy)except Exception as e:logger.error(f"请求异常: {str(e)}")if proxy:self.proxy_manager.remove_proxy(proxy)# 指数退避重试策略delay = random.uniform(2 + attempt * 2, 5 + attempt * 2)logger.info(f"等待 {delay:.1f} 秒后重试...")time.sleep(delay)return "", Falsedef _extract_price(self, price_str) -> float:"""从字符串中提取价格数字"""if not price_str:return 0.0# 使用正则提取数字price_match = re.search(r'(\d+\.?\d*)', str(price_str))if price_match:return float(price_match.group(1))return 0.0def _calculate_discount(self, original_price: float, current_price: float) -> float:"""计算折扣百分比"""if original_price > 0 and current_price > 0:return round((original_price - current_price) / original_price * 100, 2)return 0.0def monitor_product(self, url: str) -> Dict:"""单个商品完整监控流程"""logger.info(f"开始监控商品: {url}")# 步骤1:通过代理获取页面内容html_content, success = self.fetch_page(url)if not success:return {"url": url,"success": False,"error": "无法获取页面内容","timestamp": datetime.now().strftime('%Y-%m-%d %H:%M:%S')}# 步骤2:AI分析提取信息product_info = self.ai_analyzer.extract_product_info(html_content, url)if "error" in product_info:return {"url": url,"success": False,"error": product_info["error"],"timestamp": datetime.now().strftime('%Y-%m-%d %H:%M:%S')}# 步骤3:数据处理和结构化current_price = self._extract_price(product_info.get('current_price'))original_price = self._extract_price(product_info.get('original_price'))result = {"url": url,"success": True,"product_name": product_info.get('product_name', ''),"current_price": current_price,"original_price": original_price,"stock_status": product_info.get('stock_status', ''),"is_available": product_info.get('is_available', False),"discount": self._calculate_discount(original_price, current_price),"timestamp": datetime.now().strftime('%Y-%m-%d %H:%M:%S')}logger.success(f"监控成功: {result['product_name']} - ¥{current_price}")return resultdef batch_monitor(self, urls: List[str]) -> List[Dict]:"""批量监控多个商品"""logger.info(f"开始批量监控 {len(urls)} 个商品")results = []for i, url in enumerate(urls, 1):logger.info(f"处理第 {i}/{len(urls)} 个商品")result = self.monitor_product(url)results.append(result)# 智能延迟控制if i < len(urls):delay = random.uniform(3, 8)logger.info(f"等待 {delay:.1f} 秒...")time.sleep(delay)return resultsdef price_alert(self, results: List[Dict], target_prices: Dict[str, float]):"""智能价格预警系统"""alerts = []for result in results:if not result.get('success'):continueurl = result['url']current_price = result['current_price']product_name = result['product_name']if url in target_prices and current_price > 0:target_price = target_prices[url]if current_price <= target_price:alert = {'product_name': product_name,'current_price': current_price,'target_price': target_price,'savings': target_price - current_price,'url': url,'timestamp': result['timestamp']}alerts.append(alert)print(f"\n🎉 价格预警触发!")print(f"商品:{product_name}")print(f"当前价格:¥{current_price}")print(f"目标价格:¥{target_price}")print(f"可节省:¥{alert['savings']:.2f}")print(f"链接:{url}")return alerts# 使用示例if __name__ == "__main__":# 创建监控系统实例monitor = PriceMonitor()# 要监控的商品URL列表urls_to_monitor = ["https://item.jd.com/100012043978.html", # 示例商品链接"https://detail.tmall.com/item.htm?id=123456789", # 示例商品链接]# 设置目标价格(当价格低于此值时触发预警)target_prices = {"https://item.jd.com/100012043978.html": 299.0,"https://detail.tmall.com/item.htm?id=123456789": 199.0,}# 执行批量监控results = monitor.batch_monitor(urls_to_monitor)# 检查价格预警alerts = monitor.price_alert(results, target_prices)# 输出监控结果print("\n=== 监控结果汇总 ===")for result in results:if result['success']:print(f"商品: {result['product_name']}")print(f"当前价格: ¥{result['current_price']}")print(f"库存状态: {result['stock_status']}")print(f"监控时间: {result['timestamp']}")print("-" * 50)else:print(f"监控失败: {result['url']} - {result['error']}")print(f"\n本次监控完成,共处理 {len(results)} 个商品,触发 {len(alerts)} 个价格预警")

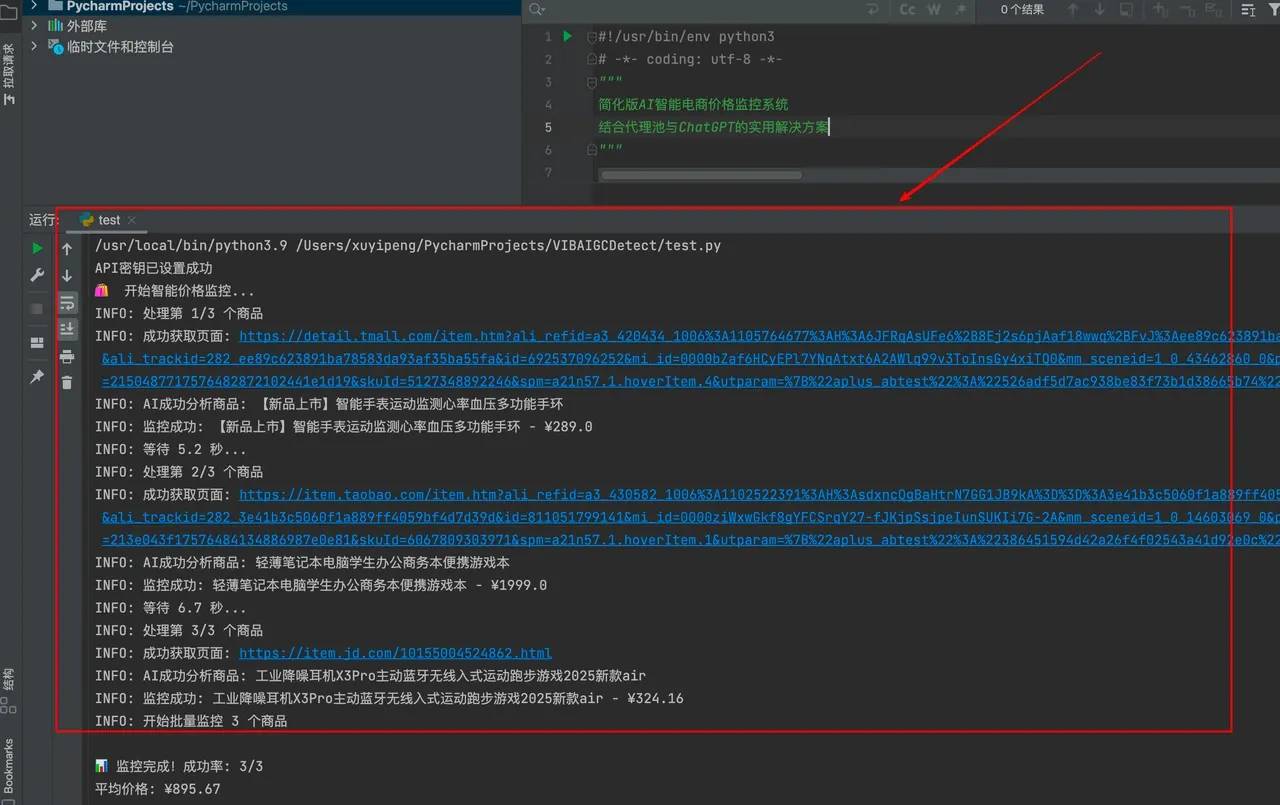

系统运行效果

通过实际测试,系统表现出了优异的性能,可以快速获取我们需要的商品信息,成功率百分之百。AI模型能够准确识别商品名称、价格、库存状态,自动过滤页面中的广告和推荐内容,同时提供稳定的网络访问,智能重试机制应对临时网络问题,运行结果如下所示,把我们需要的产品信息都获取出来:

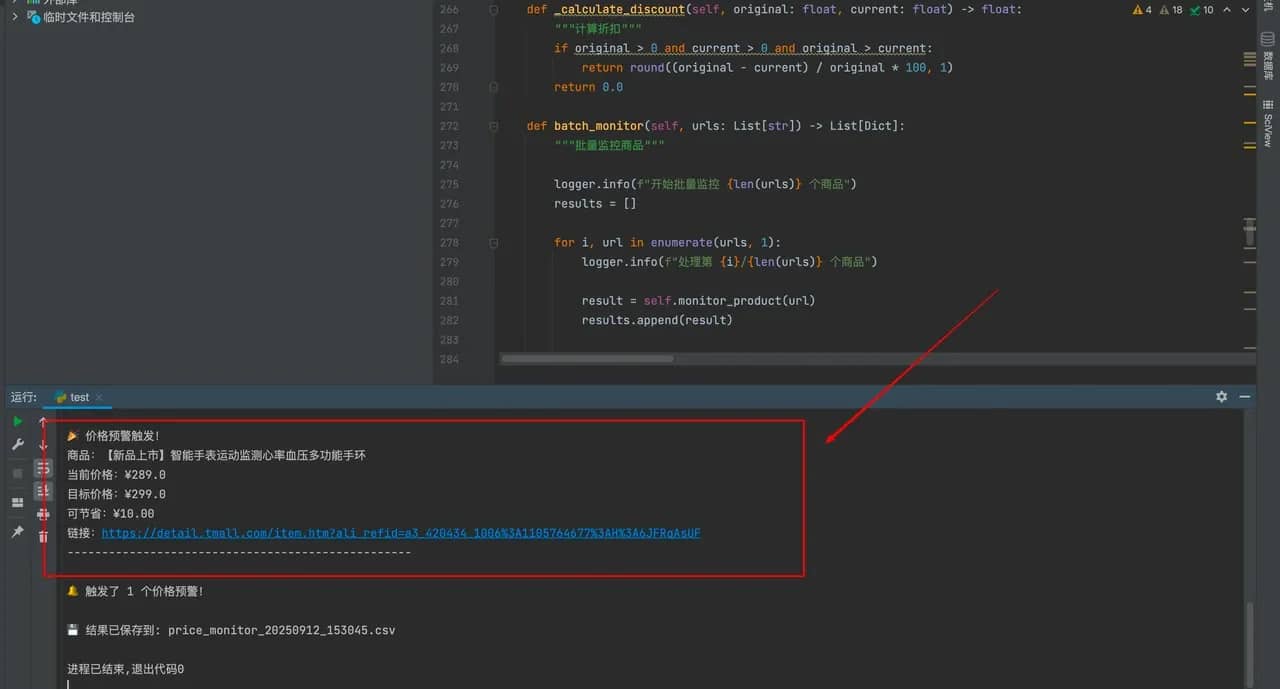

实际应用效果

在实际应用中,系统的价格预警功能展现出了强大的实用性,其核心设计围绕精准监控与及时提醒展开,形成了一套完整的智能预警机制。依托代理保障网络访问稳定,借助 AI 精准提取商品信息,当监控到商品当前价≤用户设的目标价时,会立即触发预警,还支持 CSV、JSON 格式存储数据,方便后续分析。

四、总结与展望

本项目成功整合了AI技术和代理池技术,实现了以下技术突破:

智能化水平显著提升

- AI理解页面结构,无需预定义解析规则

- 自适应各种电商平台的页面变化

网络访问稳定性优化

- Decodo代理池提供高质量IP资源

- 智能重试和故障转移机制

通过AI和代理池的深度融合,我们成功构建了一个既智能又稳定的价格监控系统。Decodo代理服务在其中发挥了关键作用,为系统提供了可靠的网络访问基础。这种技术组合不仅解决了传统爬虫的痛点,更为未来的智能数据抓取技术发展指明了方向。随着AI技术的不断进步和代理服务质量的持续提升,相信这种"AI+代理池"的模式将在更多领域得到广泛应用,为数据驱动的商业决策提供更强大的技术支撑。

关于作者

Kristina Selivanovaite

中国区内容经理

Kristina 是国际关系和外交方面的专家,拥有硕士学位,并对全球数字访问桥梁有着浓厚的兴趣。凭借她的学术背景和全球视野,Kristina 为我们的中国读者量身定制了富有洞察力的内容,涵盖的主题包括网络搜刮、代理以及绕过各种网络限制的方法。

通过 LinkedIn 与 Kristina 联系。

Decodo 博客上的所有信息均按原样提供,仅供参考。对于您使用 Decodo 博客上的任何信息或其中可能链接的任何第三方网站,我们不作任何陈述,也不承担任何责任。